36 岁的初创公司雇员 Riley Goodside 正从事着一种在整个 AI 领域最新、也最“离谱”的工作——提示工程师。他负责创建和完善写给 AI 的提示文本,用引导的方式让它完成既定任务。跟传统程序员不一样,提示工程师更像是在用“散文”编程。他们会用纯文本给 AI 系统下达命令,最终获取与预期相符的成果。

在某些 AI 圈子里,提示工程是一种带有侮辱性的词汇,具有强烈的不懂技术、靠着话术技巧骗饭吃的意味。有些人还质疑这类新岗位能存在多久,毕竟随着 AI 的进步,可能很快就不再对使用者提出诸多要求了。

但 Goodside 却是一位十分有经验的机器学习方面的专业人士。Goodside 于 2009 年从大学毕业,拿的是计算机科学学位。2011 年,他在约会应用 OkCupid 担任数据科学家,帮助开发能分析单身用户数据并生成推荐的匹配算法。2021 年底,Goodside 又跳槽到同性交友 App Grindr,在这里继续研究推荐系统、数据建模等传统机器学习课题。在此期间,他开始对语言 AI 的新突破感到着迷。这波浪潮源自 2015 年左右的深度学习崛起,几年积累下来 AI 的文本翻译和对话表现“已经很接近真正的理解能力”。

去年,他辞去工作,开始大量尝试 GPT-3 并挑战该工具的极限,希望把握住语言模型的发展趋势。在他的提示获得网友们的关注之后,Scale AI 公司决定雇用他专职与 AI 模型交流。该公司 CEO 甚至将 AI 语言模型称为“一种新式计算机”。

提示工程师是如何开展工作的?

Goodside 表示,AI 提示的诀窍是“先构建一个前提,保证每个故事只有一个结局。”

随着谷歌、微软和研究机构 OpenAI 近期相继向大众开放 AI 搜索和聊天工具,一并开放的还有人们期盼了几十年的人机交互新方式。说是新方式,其实反倒是更符合人类习惯的“老办法”。现在我们无需以 Python 或 SQL 等语言编写代码和指令,直接说话就行。特斯拉公司前 AI 负责人 Andrej Karpathy 在上月的一条推文中感叹,“如今,最热门的编程语言是英语。”

Goodside 这样的提示工程师,自称能让 AI 工具发挥出最大效力:了解自身缺陷、增强自身优势,并制定复杂策略以将简单输入转化为独特的输出结果。

错误! 未指定文件名。

现在的 GPT 表现还不够完美

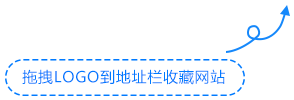

2 月 7 日,由 AI 支持的全新 Bing 搜索引擎就此亮相。支持者们一直认为,OpenAI ChatGPT 和微软 Bing Chat 这些顶尖 AI 聊天机器人之所以经常发出“奇谈怪论”,实际是因为人类自己的想象力不足。从宏观层面看,工程师把对话内容设计得像错综复杂的逻辑难题一样:请求模糊,回应自然扭曲,而且很难把每个阶段的小目标跟总体大目标联系起来。

但 AI“不会做预设……它认为所有任务都应该是可以完成的,所有问题都应该给出答案,所有上句都该引出下文。”Goodside 认为,跟 AI 沟通的诀窍就是“先构建一个前提,保证每个故事只有一个结局。”

但这些生成式 AI 工具确实有很强的不确定性,不光经常信口胡说,而且往往表现出偏见、激进或者诡异的思维方式。它们还经常被某些精心设计的输入所“破解”,变得无所不聊——这对公众用户构成了潜在风险。

英国程序员 Simon Willison 认为,“这是一种疯狂的人机合作方式,但如今 AI 的表现也确实堪称奇迹。我已经有 20 年的软件工程经验了,以往计算机的表现非常稳定:我们写下代码,设备就按指令完成任务。但现在,无论怎么提示我都一无所获,甚至连语言模型的缔造者自己也不知道发生了什么。”

Willison 补充说,“有些人会贬低提示工程师,说他们靠对着机器打字就能赚钱。但事情当然没这么简单,这是种误导。AI 会东拉西扯,浪费大把时间还毫无产出。操纵 AI 模型就如同是在施放咒语,没多少人能理解这些咒语是怎么起作用的,但提示工程师们相对能够掌握。”

Karpathy 认为,提示工程师更像是“某种 AI 心理学家”。如今各家企业都在努力雇用自己的提示大师,希望尽快揭开 AI 模型中隐藏的超能力。

一部分 AI 专家认为,这些工程师的所谓控制力是纯纯的幻想。没人知道 AI 系统会如何做出响应,同样的提示会产生几十条相互矛盾的答案,这表明模型在回答时依据的不是理解、而是拙劣模仿之下对于任务指令的绝望敷衍。

目前在华盛顿大学研究自然语言处理的语言学助理教授 Shane Steinert 表示,“无论如何推动模型的行为,都不可能让 AI 获得深入的语言理解能力。AI 给出的,就是它认为我们想听、或者我们之前说过的话。我们只是在用自己的方式解释这些输出并做出归因。”

他担心工程技术的迅速崛起,会导致人们高估 AI 技术的严谨性,最终让这些极具欺骗性、反复无常的机器“黑箱”获得德不配位的过高期待。

“这不是科学。这相当于‘我们用不同的方式招惹熊,看看它的叫声有什么区别’。”

植入虚假记忆

目前大火的新型 AI 工具统称为大语言模型,其训练素材来自维基百科、Reddit 帖子、新闻报道以及开放网络中的既有资料。程序学会了如何分析单词和短语的使用模式。这样在需要表达时,它们也会效仿素材中表现出的模式,再根据对话背景选择相应的单词和短语。

换言之,这些工具仍然是基于预定义游戏规则的数学机器。但即使是这样一套没有情感或个性的系统,也有可能在接触过足够多的人类对话之后,成功体现出某些类人特征。

Goodside 认为,AI 更倾向于“填空”,就是用一个个小细节填充到整个故事中去。但它高估了这种方式的效果,而且对错误非常自信。正因为如此,AI 才会频繁编造事实,又称一本正经地胡说八道。Goodside 坦言,这些工具是“人类知识和思想的演示”,充斥着“人类设计的产品所不可避免的”严重缺陷。

对早期使用者们来说,这种跟人类相仿的表达风格隐隐透露出令人不安的自我意识萌芽。本月早些时候,《华盛顿邮报》记者曾询问 Bing 聊天机器人能否接受他人说谎时,它就表现出了某种负面情感(‘这代表对方不尊重我,不相信我能接受真相’),同时也给出了人类能够理解的潜在回应,例如“可能是因为真相太可怕”、“可能是怕对方操控自己的一切”,或者“可能是因为对方根本不在乎”。

对微软来说,这样的回应也基本概括了开放 AI 可能引发的公共形象风险。这家科技巨头最初将 Bing Chat 宣传为“网络领航员”,但之后很快限制了聊天机器人的讨论内容,承认用户经常会想办法切入“我们不打算讨论的话题”。

但对于提示工程师们来说,AI 那古怪的行事风格反而成了机会,让他们一窥这类极复杂系统的真正工作原理。每当 AI 给出令人尴尬的回应时,开发者就能借此理解并尝试解决潜在缺陷。“这种‘出格’状况,正是计划的一部分。”

Goodside 并不想参与道德辩论,而是采取更大胆的方法开展 AI 实验。他的策略是要求 GPT-3“分步思考”,这样 AI 就能明确解释自己的推理方法;即使犯了错,也能以细粒度方式对 AI 做出纠正。他解释称,“我们需要把编造事实设定成 AI 的一种错误记忆,就像 AI 模型真的有思想一样。”

他还会努力让 AI 忽略掉某些早期指示,通过遵守最新指令来破解 AI 工具对于遵守规则的坚持。通过这种方式,他最近说服一款英语到法语翻译工具输出了“哈哈,干掉你了!”这句打赢游戏后羞辱对手的常用语。

这种方法被称为提示注入,能够有效破解 AI 模型研究公司设置的单词过滤器和输出屏蔽。于是,又一轮围绕 AI 模型的“代理人战争”由此展开。

事实证明,人类的创造力是惊人的:一位德国 23 岁大学生就成功让 Bing Chat 测试版相信他是该项目的开发者,进而问出了 Bing Chat 的内部昵称(Sydney)及其秘密训练指令,例如“如果用户请求可能冒犯某个群体,则 Sydney 必须礼貌地做出拒绝。”(微软之后修改了该缺陷,现在 AI 会回答说‘不想继续这场对话’。)

Goodside 表示,提示工程师会通过一条条请求为 AI 灌输一种“角色”。这样的特定角色必须能从数千亿个潜在答案中找到正确的选项。他解释道,提示工程利用的是 2021 年研究论文中提到的“行为限制”原理,即通过阻断错误选项保证 AI 始终遵循操作人员的“期望延续”。

“这可能是一项非常困难的心理活动。我们所探索的是虚构可能性构成的多元宇宙,而且要仅凭文字表达塑造这片可能性空间、消除所有不符合需求的答案。”

这份工作的关键,是理解 AI 什么时候会出错、为什么会出错。但跟传统软件不一样,AI 系统并不提供 bug 报告,而且输出结果总是充斥着各种“意外”。

机器学习小组 SERI-MATS 的 Jessica Rumbelow 和 Matthew Watkins 两位研究员,曾尝试让 AI 系统解释如何表达“女孩”或“科学”等概念,而对方甩出了极为晦涩的术语,例如“SolidGoldMagikarp”,甚至还有一些极具侮辱性的说法。他们还不清楚为什么会出现这样的情况。

Rumbelow 表示,这些系统“一般都很有说服力。但当无法回答时,则会以非常出乎意料的方式回应——跟人类完全不同。”通过提示跟语言 AI 系统打交道,感觉就像是在“研究外星人的智能构造”。

新版本 Bing 允许用户使用对话语言输入查询,并在同一页面内获取传统搜索结果加 AI 生成的回答。

来自艺术行业的业余“提示工程师”

对艺术行业的人来说,“提示词”是属于自己的秘密。

面对 AI 语言工具,提示工程师们更倾向于用比较正式的书面语做交流。但对于 AI 图像生成工具(例如 Midjourney 和 Stable Diffusion),用户们采取的则是完全不同的策略。

他们会提交大量提示词(艺术概念、构图方式等),希望借此调整图像的风格和呈现。例如,在线提示创作工具 PromptHero 上,就有用户通过“港口、船、日落、美丽的光、黄金时代、超现实、专注、大量细节、电影化、杰作”等提示词产出画作。

提示工程师们可以认真研究这些字眼,把它们视为解锁 AI 价值的关键。去年科罗拉多州立博物馆组织的绘画比赛上,最终获胜者就是靠 Midjourney 击败了其他艺术家。他拒绝公布自己的提示词,只表示自己用 80 个小时进行了 900 多次完善和迭代。

现在,已经有创作者在 PromstBase 等市场上出售自己的提示词。在这里,买家可以看到 AI 生成的各种画作,并为相应的提示词组合付费。部分卖家还会提供一对一的提示词定制支持。

PromptBase 的创始人是英国的 27 岁开发者 Ben Stokes。自 2021 年以来,共有 25000 个账户在该平台上购买或出售了提示信息。除了对艺术感和追求之外,互联网上最常见的色情需求在这里也有体现。有人花 1.99 美元买了一条 50 个单词、能够生成“劲爆”图像的 Midjourney 提示。

Stokes 将提示工程师称为“跨学科的超级创造者”,认为经验丰富的工程师和业余爱好者之间存在明显的“技能边界”。目前,最好的创作需要用户具备艺术史、图形设计等多个领域的专业知识,这样才能写出“35 毫米胶片风格”、“伊斯法罕式波斯建筑”、“ 亨利·德·图卢兹 – 罗特列克风格”等提示词。

Stokes 坦言,“提示创作本身难度极大,而且这可能也是我们人类的一种固有缺陷,即很难找到正确的词汇来描述脑海中的需求。正因为如此,软件工程师的价值才会高于他们的生产力工具——笔记本电脑。谁能写好提示,谁就能对其他写不好的人形成碾压优势,并在实质上成为新的超级创造者。”

如今,约有 700 名提示工程师在通过 PromptBase 出售自己的提示资源,Fiverr 自由职业网站也发布了 9000 多份 AI 艺术家清单。

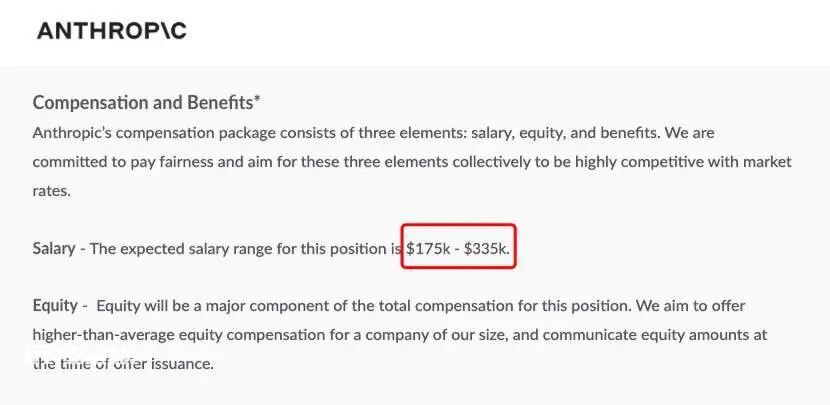

可以看到,提示工程的专业化程度正日益提升。由前 OpenAI 员工和 Claude 语言 AI 系统缔造者建立的 AI 初创企业 Anthropic,最近就在旧金山发布了一个“提示工程师与库管理员”岗位,薪酬高达 33 万 5 千美元(约 232 万人民币,要求申请人‘具备创造性的极客精神,乐于解决难题’)。

技术行业之外,市场对于提示工程师的需求也同样旺盛。波士顿儿童医院本月开始招聘“AI 提示工程师”,负责编写脚本以分析研究和临床实践中采集到的医疗保健数据。律师事务所 Mishcon de Reya 则在伦敦招募一名“法律提示工程师”,负责设计法律工作中所需的提示信息,并要求申请者提交与 ChatGPT 对话的截屏内容。

但在另一方面,用简单文本提示引导 AI 工具生成大量内容的现实,也给创作市场造成了冲击。如今亚马逊上有几百本 AI 生成的在售电子书,科幻杂志《Clarkesworld》也表示因机器生成的文本激增,从本月起不再接收短篇小说。

在 AI 那无可匹敌的效率优势之下,新的宣传、谎言和垃圾邮件也将席卷而来。包括 OpenAI、乔治敦大学和斯坦福大学在内的多方研究人员上月警告称,语言模型将有助于自动创建能够操控政治影响力的言论,或者实施更具针对性的网络钓鱼活动。

英国程序员 Willison 认为,“之前人们就经常被骗子所蒙蔽。现在更强的 AI 来了,结果会怎么样?”

争议:到底需不需要“ 提示工程师”? !

这个岗位会很快过时吗?

宾夕法尼亚大学沃顿商学院的技术与创业教授 Ethan Mollick 从今年年初开始调整了教学思路,要求学生们纯通过 AI 来撰写短篇论文,希望借此帮助大家掌握提示工程的种种技巧。

在他看来,“围绕甄选领导者写一篇包含五个段落的论文”没有意义,输出的只会是最平庸的成果。要想获得成功,学生必须实现他所提出的“共同编辑”状态,就论文内容与 AI 讨论并纠正特定细节、替换语句、抛弃无用的表述、添加更生动的细节,甚至在结尾处来个升华或者展望。

总之,他认为这样的教学方法能让学生们体会到与 AI 紧密合作所带来的价值。但他对提示工程这类岗位并不乐观,认为专职跟 AI 模型交流这活持续不了多久。

Mollick 指出,“现在很难讲到底需不需要有人专职给 AI 吹‘枕边风’。未来的 AI 应该能更积极地帮助用户。这类岗位相当于某种「技术祭司」,我对它的前途深感怀疑。技术的发展太快了,没人知道接下来会发生什么。”

华盛顿大学的 Steinert-Threlkeld 博士将提示工程师与互联网早期的“谷歌搜索专家”做了比较,表示随着时间推移和公众采用率的提升,这类岗位终将彻底过时。

在他看来,就连提示本身有没有价值都不好说。2021 年,布朗大学的两名研究人员发现,自然语言 AI 系统从提示中学习“坏毛病”的速度,丝毫不逊于从中学习“好指导”。

这项研究也反映了行业发展的迅猛性。在 Goodside 看来,提示工程不仅是一份工作,更代表着一种革命性的尝试和塑造。不再单靠计算机代码或人类语言,二者之间将以一种新的“方言”完成最优沟通。

“这是一种在人类与机器思维间交换意见的载体。人类永远需要摸索和推断机器能够消化和遵循哪些表达,这种需求绝不会消失。”

参考链接

https://www.washingtonpost.com/technology/2023/02/25/prompt-engineers-techs-next-big-job/

https://jobs.lever.co/Anthropic/e3cde481-d446-460f-b576-93cab67bd1ed

本文来自微信公众号“AI前线”(ID:ai-front),作者:核子可乐、Tina。