近年来,随着 3D 电影和虚拟现实的发展,光场技术引起了相关研究人员的极大关注。光场(Light Field)是空间中光线集合的完备表示,采集并显示光场就能在视觉上重现真实世界。

光场是属于光学和计算机的交叉领域,国内外都有许多科研小组在跟进研究,自2011年 Magic Leap 公司成立以来,光场技术进入大众消费视野,谷歌、微软、腾讯和facebook等前沿科技公司也都在跟进布局。

曹煊博士毕业于中国科学院自动化研究所,目前系腾讯优图实验室高级研究员。曹煊博士致力于光场技术相关研究,其在2017年发布的博士论文中,采用光场4D 模型建立了统一的理论框架,并在此基础上深入研究了光场采集和显示的系统原理,提出了创新的算法和系统。同时曹煊博士致力于光场技术科普,其在社交平台上发布的光场系列文章是国内少有的光场领域优质科普内容。

本文搜集整理了曹煊博士的研究成果及国内外光场领域最新资讯,零度资本经授权发布。

一、光场的概念

在人类的五大感知途径中,视觉占据了70%~80%的信息来源;而大脑有大约50%的能力都用于处理视觉信息 。

人眼能看见世界中的物体是因为人眼接收了物体发出的光线(主动或被动发光),而光场就是三维世界中光线集合的完备表示。 人眼能看见世界中的物体是因为人眼接收了物体发出的光线(主动或被动发光),而光场就是三维世界中光线集合的完备表示。然而,现有的图像采集和显示丢失了多个维度的视觉信息。这迫使我们只能通过二维“窗口”去观察三维世界。

定义: 光场(Light Field)是空间中光线集合的完备表示。采集并显示光场就能在视觉上重现真实世界。

理论模型: 如果有一个体积可以忽略不计的小球能够记录从不同角度穿过该小球的所有光线的波长,把该小球放置在某个有限空间中所有可以达到的位置并记录光线波长,那么就可以得到这个有限空间中某一时刻所有光线的集合。在不同时刻重复上述过程,就可以实现7D全函数的完备采集。

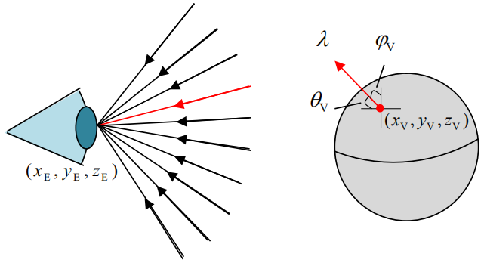

7维全光函数(Plenoptic Function)P(x, y, z, θ, Φ, λ, t),每一条光线的唯一函数表示 P(x轴,y轴,z轴,水平面角度/‘θi:tə/ ,垂直面角度/fai/ ,颜色/’læmdə/ ,飞行时间)用(x, y, z)表示人眼在三维空间中的位置坐标。光线可以从不同的角度进入人眼,用(θ, Φ)表示进入人眼光线的水平夹角和垂直夹角。每条光线具有不同的颜色和亮度,可以用光线的波长(λ)来统一表示。进入人眼的光线随着时间(t)的推移会发生变化。因此三维世界中的光线可以表示为7个维度的全光函数(Plenoptic Function, Plen-前缀具有“全能的、万金油”的意思)

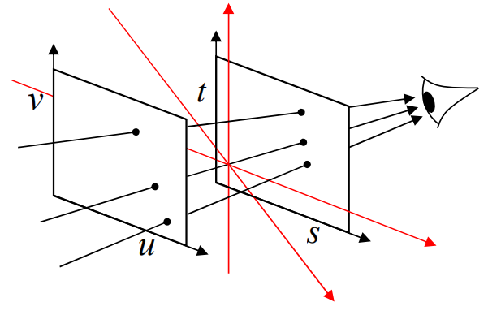

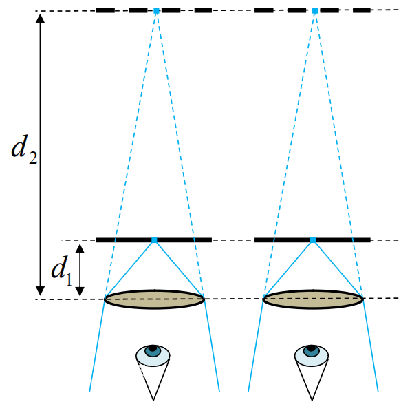

光场采集—4D光场模型 P(u,v,s,t):按照当前的计算机技术水平,难以对7D光场这么庞大的数据进行实时处理和传输。因此有必要对7D光场进行简化降维。美国斯坦福大学的Marc Levoy将全光函数简化降维,提出(u,v,s,t)4D光场模型[9]。Levoy假设了两个不共面的平面(u,v)和(s,t),如果一条光线与这两个平面各有一个交点,则该光线可以用这两个交点唯一表示。Levoy提出的4D模型既降低了表示光场所需的维度,同时又能完备表示人眼成像所需要的全部光线。光场4D模型得到了学术界的广泛认可,关于光场的大量研究都是在此基础上展开。

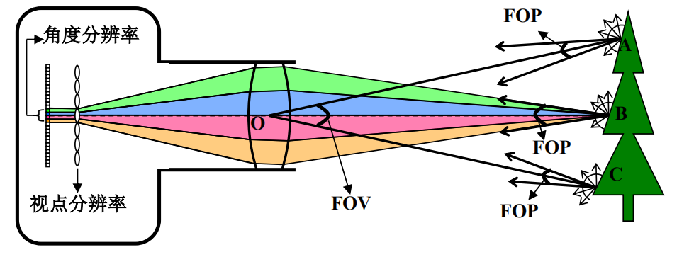

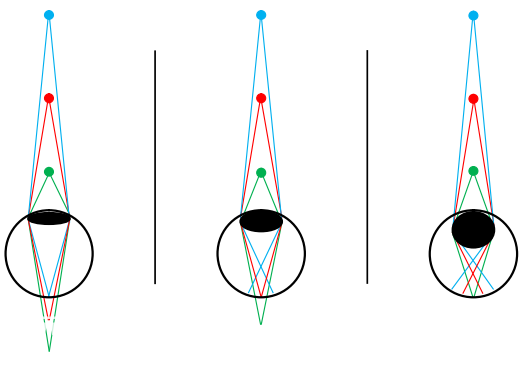

衡量4D光场的指标不仅有图像分辨率和视场角FOV,还有角度分辨率(表征了一个发光点在FOP角范围内的光线被离散化的程度, 图中B点在FOP角度范围内的光线被微透镜分成4×4束光线,光场相机的角度分辨率即为4×4,而基于小孔成像模型的普通相机的角度分辨率始终为1×1)和视差范围FOP(Field Of Parallax, 被光场相机采集到的光线的角度范围决定了能够观察的最大视差范围,我们记这个角度为FOP )。

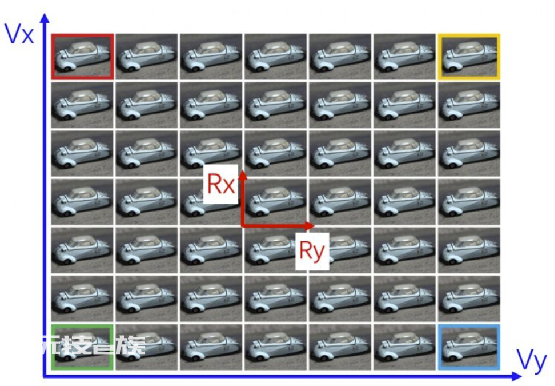

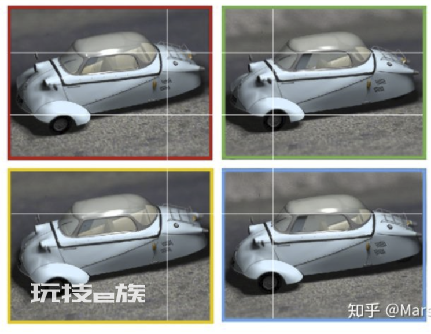

基于4D光场模型采集光场的显示,4D光场数据可以表示为P(Vx, Vy, Rx, Ry),其中(Vx, Vy)表征了角度分辨率,表示有Vx*Vy个视点(View)图像;(Rx, Ry)表征视点图像分辨率,表示单个视点图像的分辨率为Rx*Ry。如图展示了7×7光场的可视化,表示共有49个视点图像,每个视点的图像分辨率为384×512。P(7,7,384,512)视点图像分辨率越高,包含的细节越多。角度分辨率越高,单位角度内视点数量越多,视差过度就越平滑。

研究光场的实践意义:让人眼能看见更真实的三维世界采集角度。如智能驾驶,专注于模拟人的大脑,但忽视了“眼睛”的重要性,视觉输入信息的完备,能够让计算机更好的处理图像数据进而做出更准确的决策。显示角度。如 LCD/OLED显示屏, 只能呈现光场中(x, y, λ, t)四个维度的信息,而丢失了其他三个维度的信息。(缺失z深度信息;缺失θ, Φ角度信息,观众从上下左右各个方向看显示屏,看到的是一样的内容)军事沙盘、远程手术等工业应用,平面显示缺陷明显。社交、娱乐、远程会议等消费应用,三维显示想象空间无穷

二、人眼成像原理

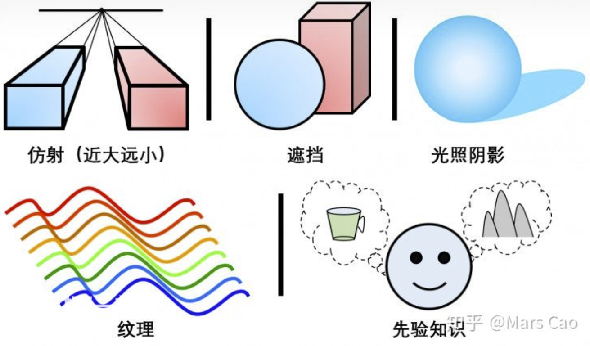

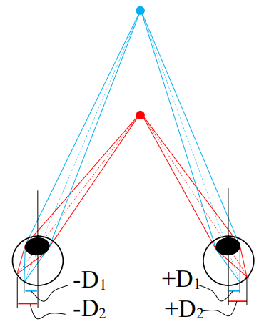

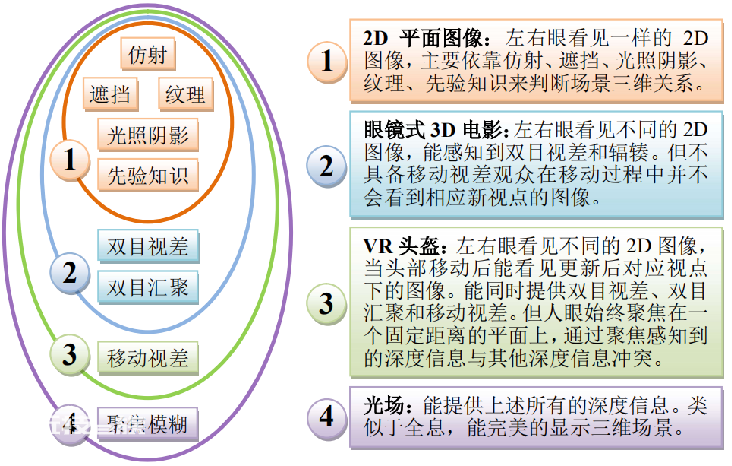

人眼产生三维立体视觉来源于 心理感知和 生理感知。 心理感知主要是通过仿射、遮挡、光照阴影、纹理、先验知识五方面的视觉暗示,从而“欺骗”大脑感知到三维信息,如图所示,尽管是在平面上绘图却能产生一定的三维视觉。 仿射:其直观的感受是“近大远小”,随着物体与人眼的距离减小,物体在人眼的成像越大。 遮挡:更近的物体会遮挡更远的物体,通过相互遮挡关系可以判断物体间的相对远近关系。 光照阴影:不同方向的光照会在物体表面产生不同的阴影,通过对阴影模式的判断可以推断物体的三维形状。 纹理:通过有规律重复的动/静态特征分布产生立体视觉。 先验知识:人类在观看大量物体以后会总结一些基本的经验,例如天空中的飞机和风筝都非常小,但飞机比风筝距离人眼更远。立体视觉的生理感知主要包括双目视差、移动视差、聚焦模糊双目视差(Binocular Parallax):人的双眼在水平方向上间隔大约 53~73mm, 由于左右眼的间隔,场景中的同一物体在左右眼视网膜上的成像位置会略微不同, 这种视网膜上成像位置的差距称为双目视差。为了避免左右眼视差所产生的重影,人眼会动态的调节视线的汇聚方向。通过双眼汇聚的角度可以判断物体的远近。双目视差的感知必须依靠双目协同工作才能完成。

双目视差示意图

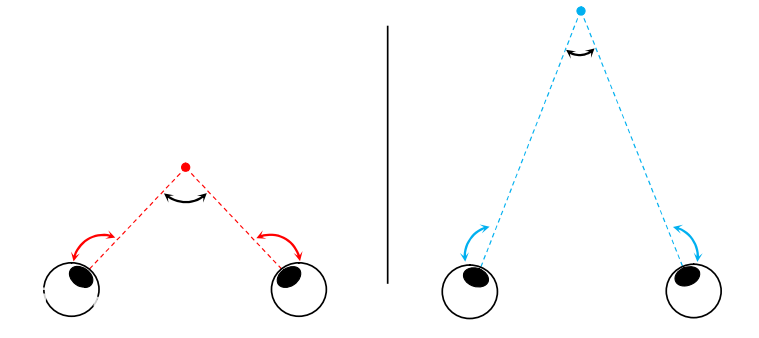

双目汇聚示意图移动视差(Motion Parallax):当移动头部来观察场景时,场景中的物体会在视野中产生相反方向的移动,但远近不同的物体在人眼中产生的位移大小会不同。

移动视差示意图聚焦模糊(Focus):为了看清楚远近不同的物体,人眼通过收缩或舒张睫状肌可以改变晶状体的形状,从而聚焦在远近不同的平面上,类似于相机的聚焦功能。

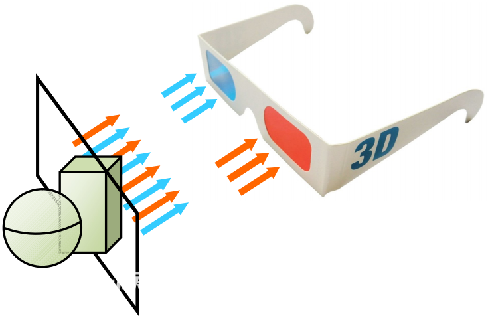

聚焦模糊示意图人眼立体成像原理-3D电影(双摄像机采集,双镜片输入人眼,人脑处理)在生理层面提供双目视差的刺激,由大脑融合成立体信息;心理感知层面提供上述仿射、遮挡、光照阴影、纹理、先验知识这五种心理感知信息。3D电影通过一副眼镜过滤两幅具有细微偏差的图像分别呈现给左右眼,让人眼感知到双目视差,由大脑融合左右眼图像产生三维信息。

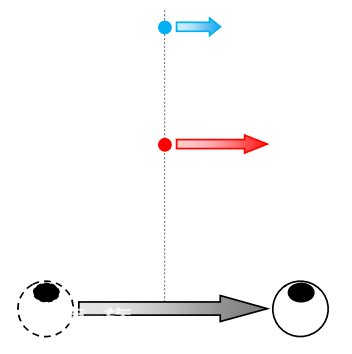

眼镜式3D电影工作原理示意图P(x, y, λ, t)没有z深度信息(光线都来自于同一个平面),也没有各向异性的光线信息(坐在影院的各个地方看到的是一样的图像),主要是以双目视差形成刺激“欺骗”大脑自动合成立体影像。由于缺乏移动视差和聚焦模糊,观看3D电影时双目视差告诉大脑看到了3D场景,而移动视差和聚焦模糊又告诉大脑看到了2D场景,大脑会在3D和2D这两种状态之间不停的切换。由于双目视差与移动视差和聚焦模糊之间的冲突,从而导致“烧脑”、“头晕”。人眼立体成像原理-VR头盔(多摄像头采集,电脑融合处理,双镜片输入,人脑处理)在生理层面呈现双目视差+移动视差的生理刺激, 由大脑融合成相对3D电影更强的立体信息,心理感知层面提供上述仿射、遮挡、光照阴影、纹理、先验知识这五种心理感知信息。虚拟现实(Virtual Reality,VR)头盔能提供比 3D 电影更多的立体信息,视觉 体验更丰富。

虚拟现实(VR)的成像光路示意图P(x,y, θ, Φ ,λ,t)没有z深度信息(光线都来自于同一个平面)通过6DOF传感器感知人的移动提供对应的影响,模拟各向异性的光线信息( θ, Φ )仍然缺乏聚焦模糊,和双目视差、移动视差产生冲突导致VAC难题。例如,真实环境中人眼看到远处的高山和近处的人物是分别接收了从远近不同地方发出的光线,然而VR屏幕中出现的高山和人物都是从距离人眼相同距离的显示屏上发出的光线。无论人眼聚焦在“远处”的高山还是“近处”的人物,睫状肌都是处于相同的屈张程度,这与人眼观看实际风景时的聚焦模糊状态是不相符的。随着显示技术的演进,显示设备能提供越来越丰富的视觉感知信息。根据所能呈现的视觉信息,可以将显示设备分为4个等级。

多种显示设备与三维视觉信息对应包含关系

三、光场的采集

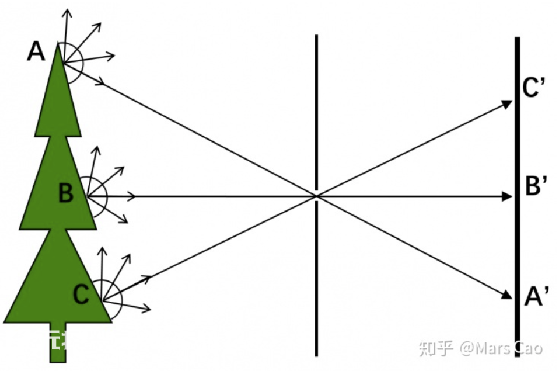

照相机/摄影机(x, y, λ, t):人眼和照相机成像机理的对比。小孔成像模型(200年前发明应用至今的照相机原理)是光场成像的一种降维形式,只采集了P(x, y, λ, t)四个维度的信息。

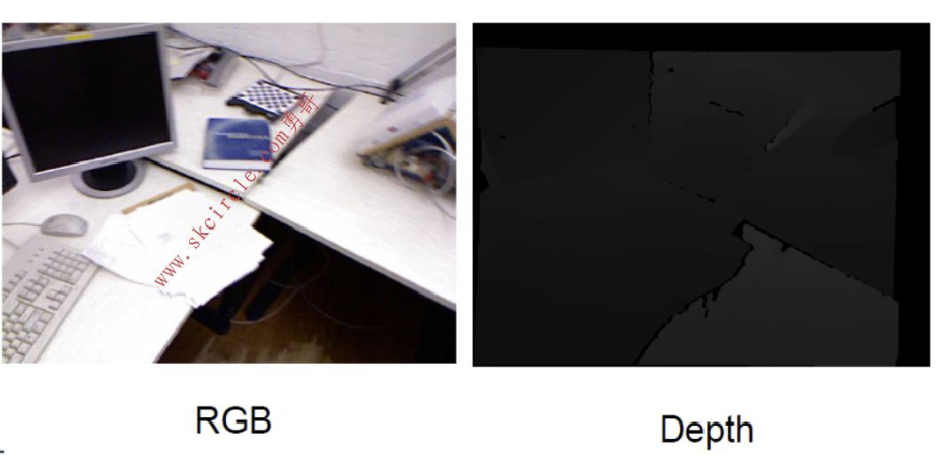

小孔成像深度RGB-D相机(x, y, z, λ, t):RGB-D深度相机是近几年兴起的新技术,从功能上来讲,就是在RGB普通摄像头的功能上添加了一个深度测量,通过深度相机获取到的数据,我们能准确知道图像中每个点离摄像头距离,这样加上该点在 2D 图像中的(x,y)坐标,就能获取图像中每个点的三维空间坐标(x,y,z)。通过三维坐标就能还原真实场景,实现场景建模等应用。

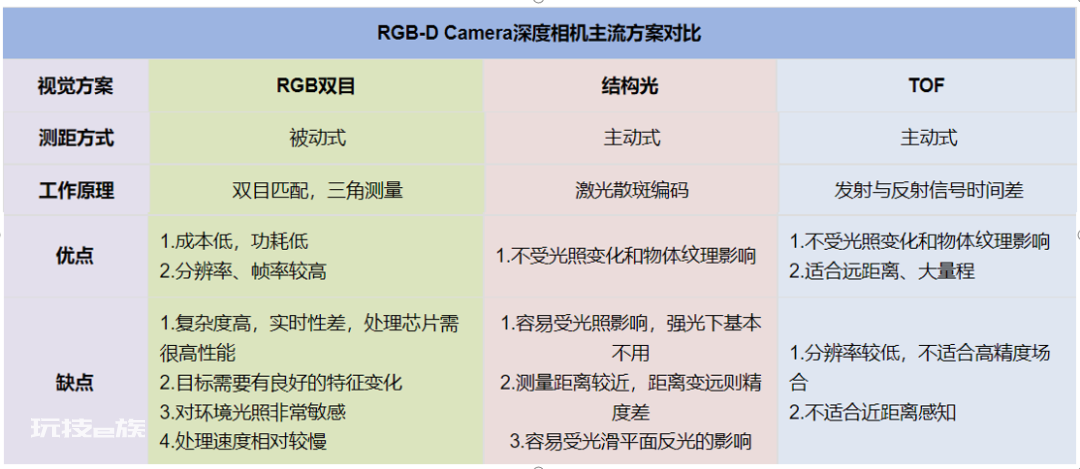

深度相机有以下几种主流方案:双目,结构光,TOF。

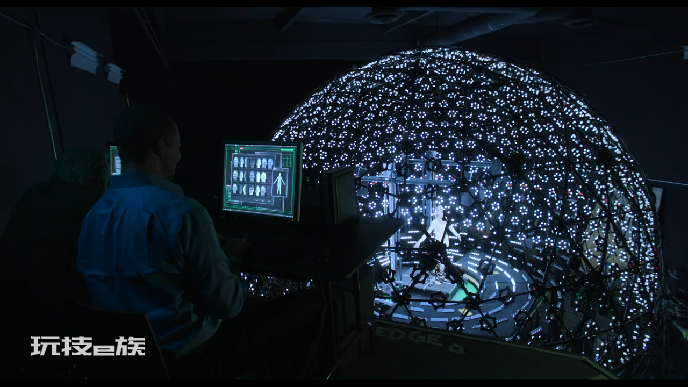

全光场装置 P(x, y, z, θ, Φ, λ, t):根据7D全光函数的描述,如果有一个体积可以忽略不计的小球能够记录从不同角度穿过该小球的所有光线的波长,把该小球放置在某个有限空间中所有可以达到的位置并记录光线波长,那么就可以得到这个有限空间中某一时刻所有光线的集合。在不同时刻重复上述过程,就可以实现7D全函数的完备采集。

2013年的科幻电影《未来学大会》中将女演员全息数字化,进行光场采集的场景基于4D光场模型的微透镜阵列光场相机:基于微透镜的光场采集方案是商业化光场相机主要采用的方案,目前已经商业化的光场相机主要包括美国的Lytro、德国的Raytrix和中国的奕目科技。奕目(上海)科技有限公司(上海交通大学科技成果转化,国内对标德国Raytrix的创业公司)2019年成立, 为上海交通大学科技成果转化企业,“全面掌握光场相机涉及的光学设计、微纳加工、光场芯片封装封测、光场算法、3D工业软件等全链路核心技术,领头制订国内光场相机的行业标准“单相机、单次拍照、被动式大景深三维成像”2020年完成千万元融资(深圳力合创投),2022年6月完成千万元融资(经纬创投)应用领域:工业应用,机器视觉,分层检测。

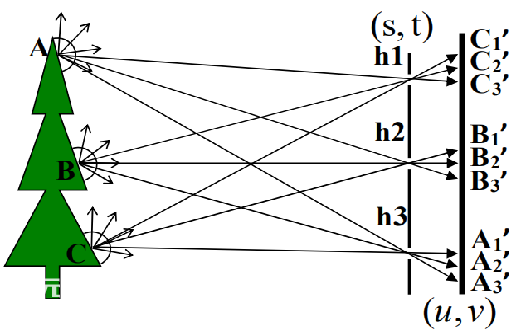

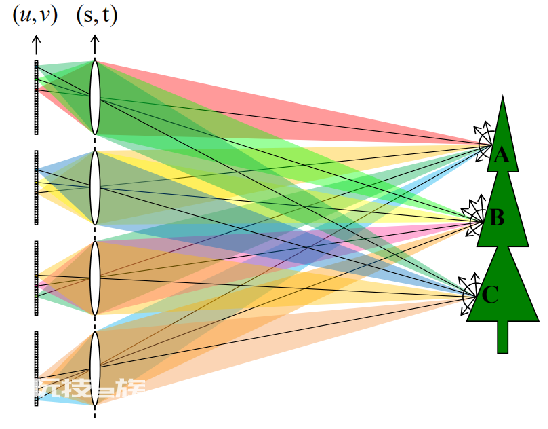

奕目科技的基于微透镜阵列的工业光场相机基于4D光场模型的相机阵列光场相机:基于相机阵列的光场采集不需要对相机进行改造,但需要增加相机的数量。光 线从物体表面发出,分别进入多个相机镜头,并分别被对应的成像传感器记录。如图 2.8 所示,A 点在半球范围内发出各向异性的光线,其中一定角度范围内的光线 进入了相机阵列,并被分成 4×4 束光线,每束光线被对应的镜头聚焦在成像传感器上,由此 A 点各向异性的光线被离散化为 4×4 束并被分别记录。

相机阵列采集光场原理示意图

Lytro2017年推出的第一代相机阵列工业光场相机Google Project Starline:2021年谷歌 I/O 大会公布:全息视频聊天技术 Project Starline, 类似3D 视频聊天室,旨在取代一对一的 2D 视频电话会议,让用户感觉就像坐在真人面前一样。实际上,这是由高分辨率传感器、数十个景深扫描传感器以及 65 英寸「光场显示器」重新生成的实时 3D 模型。谷歌表示这一项目已开发了数年之久,其背后是大量光场采集、计算机视觉、机器学习、空间视频和音频压缩传输技术

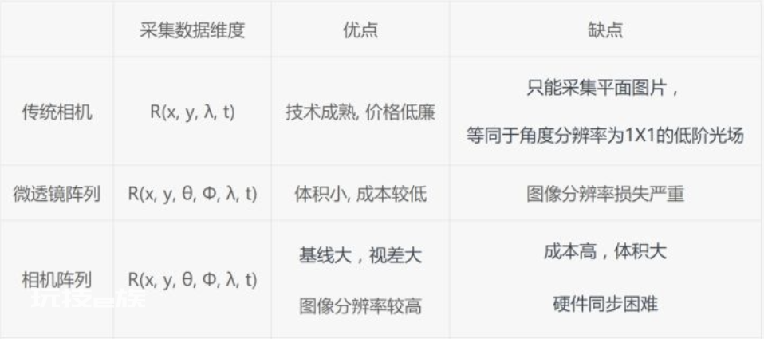

Google Project Starline基于4D光场模型的光场相机方案比较:基于微透镜阵列的光场采集具有体积小巧,硬件成本低等优点。但其缺点也很明显:1)光场视点图像分辨率损失严重,随着视点数量的增加,单个视点分辨率急剧降低。2)受到相机光圈的限制,光场中可观察的视差范围较小。基于相机阵列的光场采集相比基于微透镜阵列的光场采集具有更多优点:1)视点分辨率不损失,由单个相机成像传感器决定。2)光场的视差范围更大。但基于相机阵列的光场采集仍然面临两个问题:1)需要的相机数量较多,硬件成本高昂,例如采集7×7视点的光场需要49个相机。2)相机同步控制复杂,数据量大,存储和传输成本高。

四、光场的显示

平面显示(二维采集,二维输出):在生理层面无法提供立体信息,心理感知层面提供仿射、遮挡、光照阴影、纹理、先验知识这五种心理感知信息,P(x, y, λ, t)。平面显示(三维采集,计算机处理,二维输出):2013年周杰伦演讲会,还原邓丽君的跨时空合唱,动用45名特效师,耗时2个多月,耗资1亿新台币(约合人民币2202万元)。“小马奔腾找到Digital Domain,Digital Domain找到南加州大学的ICT,又找了一个跟邓丽君长得极像的人,用他们的light stage做了扫描。“Digital Domain ( 数字领域),又名数字王国,简称D2 ,位于美国加利福尼亚州的威尼斯( Venice of California ) ,是一家在美国名气仅次于工业光魔的特效公司。

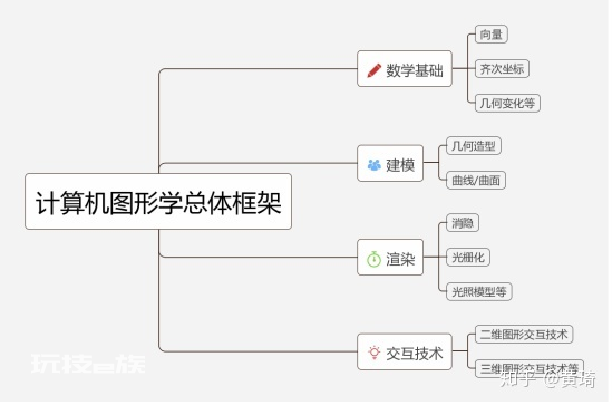

CG(无光采集过程,使用计算机通过各种建模、渲染技术构造图形 ):计算机图形学(CG,Computer Graphics)国际标准化组织 ISO 定义:计算机图形学是一门研究通过计算机将数据转换成图形,并在专门显示设备上显示的原理方法和技术的学科。它是建立在传统的图学理论、应用数学及计算机科学基础上的一门学科。计算机图形学是研究怎样利用计算机来显示、生成和处理图形的原理、方法和技术的一门学科,这里的图形是指三维图形的处理。

3D电影(双摄像机采集,双镜片输入人眼,人脑处理):在生理层面提供双目视差的刺激,由大脑融合成立体信息;心理感知层面提供上述仿射、遮挡、光照阴影、纹理、先验知识这五种心理感知信息。3D电影通过一副眼镜过滤两幅具有细微偏差的图像分别呈现给左右眼,让人眼感知到双目视差,由大脑融合左右眼图像产生三维信息P(x, y, λ, t)没有z深度信息(光线都来自于同一个平面),也没有各向异性的光线信息(坐在影院的各个地方看到的是一样的图像),主要是以双目视差形成刺激“欺骗”大脑自动合成立体影像。由于缺乏移动视差和聚焦模糊,观看3D电影时双目视差告诉大脑看到了3D场景,而移动视差和聚焦模糊又告诉大脑看到了2D场景,大脑会在3D和2D这两种状态之间不停的切换。由于双目视差与移动视差和聚焦模糊之间的冲突,从而导致“烧脑”、“头晕”。VR/AR头盔(多摄像头采集,电脑融合处理,双镜片输入,人脑处理):2021年VR设备出货量达到构成生态拐点,当前Oculus一家独大。2021年全年1095万台VR头显中,超65%的销量来自于Oculus。2022年预计全行业出货量1500万台,其中Oculus仍然有望吃掉60%以上的份额。(IDC预测数据)AR设备出货量较低,支持AR功能的智能手机相对有限。全球AR设备2020年出货量仅达22万台,2021年达28万台,较VR设备出货量有明显差距。( Wellsenn数据)Magic Leap,成立于2011年,于2018年推出了一款售价为2300美元的头盔Magic Leap one,前6个月仅售出约6000台。2021年10月最新融资5亿美元,投后估值20亿美元,公司历史累计融资超过35亿美元。公司当前正在筹备第二款工业级产品Magic Leap 2。在Magic Leap One上市之前,所有商业化的显示设备都是在追求分辨率、色彩还原度等指标的提升,而从来没有显示维度的突破。Magic Leap One是目前全世界范围内第一款具有大于1层呈像平面的商业化头戴显示设备。Magic Leap One的2层呈像平面相比HoloLens的1层呈像平面在视觉体验上并不会带来明显的改善,但是在对长期佩戴所引起的疲劳、不适、近视等问题是会有所改善的。

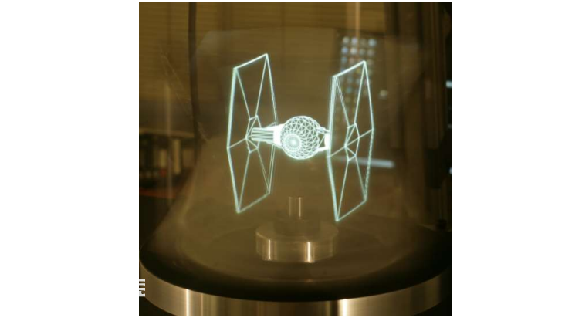

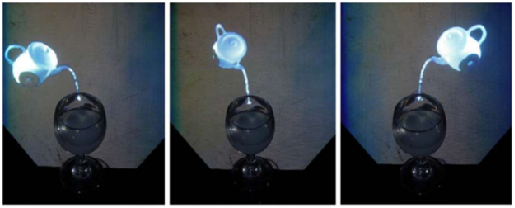

2018年推出的Magic Leap one三件套全息显示(光场设备采集,光场设备显示):在生理层面呈现双目视差+移动视差+聚焦模糊的全部生理刺激,心理感知层面提供上述仿射、遮挡、光照阴影、纹理、先验知识这五种心理感知信息。光场采集技术相对更成熟,在某些To B领域已经基本达到可以落地使用的程度。光场采集主要是提供3D数字内容,一次采集可以推广使用,这并不要求由个体消费者来完成,一般都是由一个团队来完成。因此对于光场采集系统的硬件成本、体积、功耗有更大的可接受度。相比之下,光场显示是偏向To C的产品,个体用户在成本、体积、功耗、舒适度等多方面都极度挑剔。光场显示在多个高校和科研机构已经完成了原形样机的开发,在通往商业化实用的道路上,目前最大的挑战就在于光场显示设备的小型化和低功耗。在光场显示技术发展过程中,出现了多种光场显示技术方案,引起广泛关注和研究的主要有五种技术: 体三维显示(Volumetric 3D Display);多视投影阵列(Multi-view Projector Array);集成成像(Integral Imaging);数字全息;多层液晶张量显示。(1)体三维显示(Volumetric 3D Display):原理:利用人眼视觉暂留特征,通过在空间中不同深度平面显示不同图像来实现。一体三维显示技术原理简单,实现了有限的空间内反射场函数中的5个维度P(x, y, z, λ, t),高速且匀速的往返直线运动难以实现,实践中多在体三维显示系统中将平移运动转化为旋转运动。从90年代开始有科学家做出装置,美国南加州大学Andrew Jones于2007年研制了360°体显示系统;Jones在2009年进一步将人脸实时重建技术加入到光场显示系统,实现了远程裸眼3D视频会议;中科院自动化研究所于2007研制出基于DMD高速投影仪的体三维显示系统Helix。

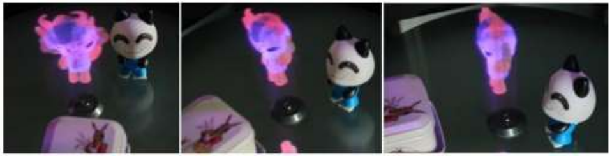

美国南加州大学Andrew Jones实现的360度光场显示(2)多视投影阵列光场显示:原理:通过多个投影仪组成的阵列向空间中一定角度范围内不同方向投射不同图像。缺点:成本高昂、占地空间大

浙江大学 360 度多视三维显示系统(2012)

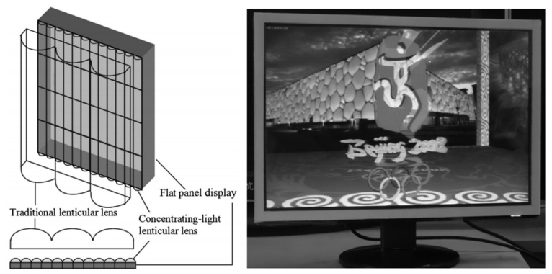

北京理工大学 360 度悬浮光场显示(2015)(3)微透镜阵列/光栅光场显示:原理:利用柱面透镜光栅将不同像素的光线投射到不同的方向实现各向异性显示缺陷:视点图像分辨率损失严重。例如采用4K显示(4096×2160),一般商业化的裸眼3D显示器在水平方向产生16(或32)个视点,则每个视点的分辨率降低到256×2160。优点:成本低廉,成为了目前唯一大面积商业化应用的裸眼3D显示方案。

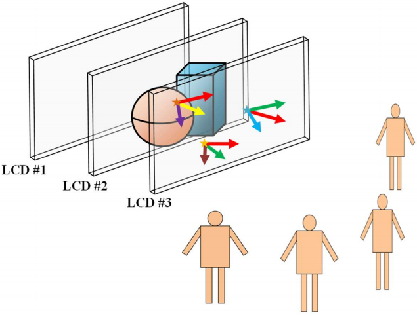

四川大学采用两层柱面光栅叠加实现的集成成像 3D 显示(2010)(4)多层液晶联合调制4D光场显示屏:传统2D显示器每个像素点都会在一定角度范围内发出光线,但每个像素点发出的光线都是各向同性的。产生各向异性的光线是光场显示的关键。将传统的液晶显示器多层堆叠起来可以构造如图19中光场4D模型,待显示的物体向各个方向发出的光线都可以被多层液晶重现,从而确保多层液晶前不同位置的观众可以接收到不同的光线,不同位置的观众可以看见三维物体的不同侧面。

多层液晶光场显示原理示意图中科院自动化所的曹煊博士2017年采用 ASUS VG278H 液晶显示器作为原始液晶面板搭建了三层液晶光场显示样机,用 DirectX 开发了多层液晶驱动程序,并成功显示了多个不同光场内容。

多层液晶光场样机显示鱼模型

零度资本投资部 冯锐综合整理(非经零度创新创业独家授权,不得转载)

本文来自微信公众号“零度资本”(ID:LingduCapital),作者:曹煊。