神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:ChatGPT 这段时间抢了 AI 领域大部分的风头。但近日谷歌推出的一款具备视觉能力,且不需要特殊训练就能引导机器人的 AI 模型 PaLM-E 也展现出了令人印象深刻的能力。这款迄今为止规模最大的视觉语言模型表现出来的涌现能力,令人对通用人工智能遐想联翩。文章来自编译。

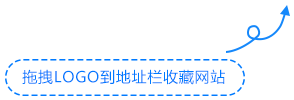

PaLM-E控制的一个机械臂伸手去拿一袋薯片。Google Research

本周一,来自谷歌与柏林工业大学的人工智能研究人员小组推出了一个多模态具象化视觉语言模型 (VLM),它的名字叫做 PaLM-E,该模型的参数规模达到了 5620 亿个,里面集成了用于控制机器人的视觉与语言。研究人员声称,这是有史以来规模最大的 VLM,无需重新训练即可执行各种任务。

根据谷歌的说法,只需要给 PalM-E 下达一条高级命令,比如“把抽屉里的米饼拿给我”,它就可以给一个带机械臂的移动机器人平台(由谷歌机器人开发)生成行动计划,然后自行执行。

PaLM-E 是通过分析来自机器人摄像头的数据来实现这一点的,整个过程不需要对场景表示进行预处理。这样一来,就不需要人类进行预处理对数据做出注释,机器人的控制也可以更加自主。

在谷歌提供的演示视频中, PaLM -E 执行“从抽屉里给我拿袋米片”的指令,其中包括多个计划步骤,还要结合来自机器人摄像头的视觉反馈。

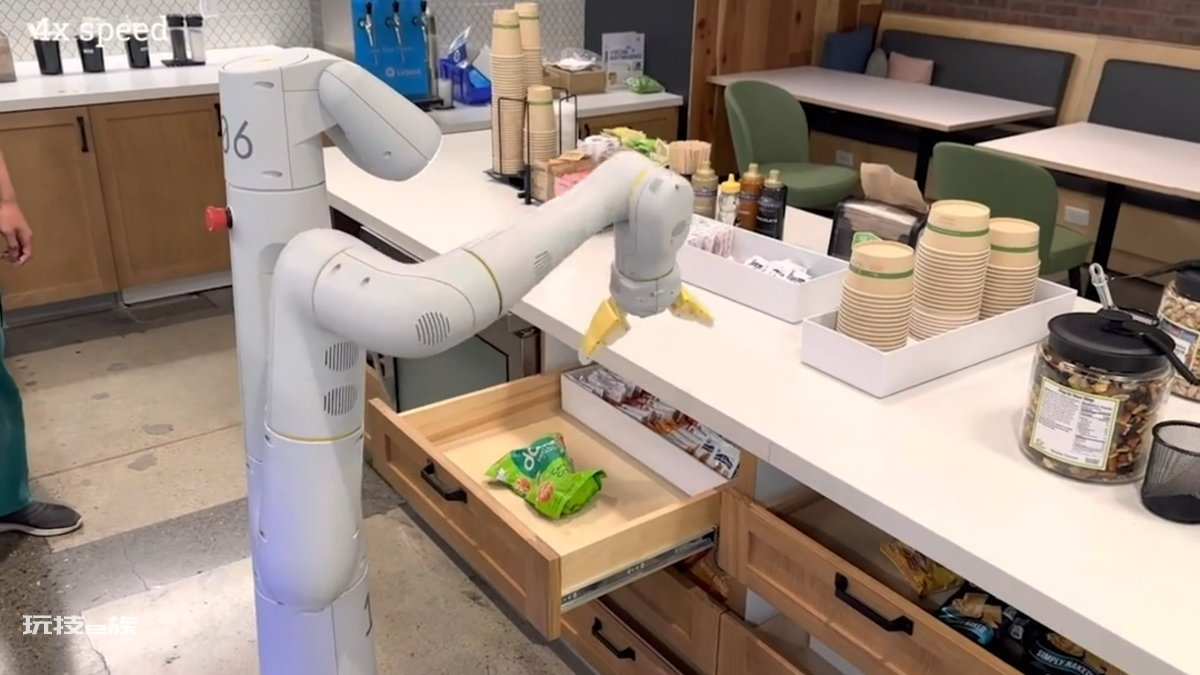

这个模型还具备弹性,可对环境做出反应。比方说,PaLM-E 模型可以引导机器人到厨房取出米饼袋,由于将 PaLM-E 集成到了操控系统之中,它可以对任务期间可能发生的中断具备耐受力。在一个视频示例里,研究人员好几次把机器人拿起的米饼袋又放了回去,但机器人会重新找到米饼袋然后再拿起来。

在另一个示例里,展示了同一个 PaLM-E 模型通过有着复杂序列的任务自主控制机器人。此前,这样的任务往往需要人工指导。谷歌的研究论文解释了 PaLM-E 是如何将指令转化为动作的:

我们展示了 PaLM-E 在具有挑战性以及多样化的移动操控任务上的表现。在设置上我们主要遵循的是 Ahn 等人的设置。 (2022),也就是机器人需要根据人类的指令来计划一系列的导航并操纵动作。比方说,给出指令“我把饮料给弄洒了,你能给我拿点东西来清理一下吗?”后,机器人需要规划一个包含有“1. 找到海绵,2. 捡起海绵,3. 拿海绵给用户,4. 放下海绵”的动作序列。在这些任务的启发下,我们开发了 3 个用例来测试 PaLM-E 的具身化推理能力:拟合性预测(affordance prediction)、故障检测以及长期规划(long-horizon planning)。底层控制策略(low-level policies)来自 RT-1 (Brohan et al., 2022),这是一种 transformer 模型,它可以利用 RGB 图像以及自然语言指令,然后输出末端执行器控制命令。

PaLM-E 属于“下一个标记预测器”(next-token predictor),之所以叫做“PaLM-E”,是因为它的基础是谷歌所谓的“PaLM ”大型语言模型 (与 ChatGPT 背后的技术类似)。通过添加感官信息以及机器人控制,谷歌让 PaLM “具象化”了。

由于它的基础是语言模型, 所以 PaLM-E 能对比方说图像或传感器数据进行连续观察,并将它们编码为一系列与语言标记规模相同的向量。这样模型就能以与处理语言相同的方式去“理解”感官信息。

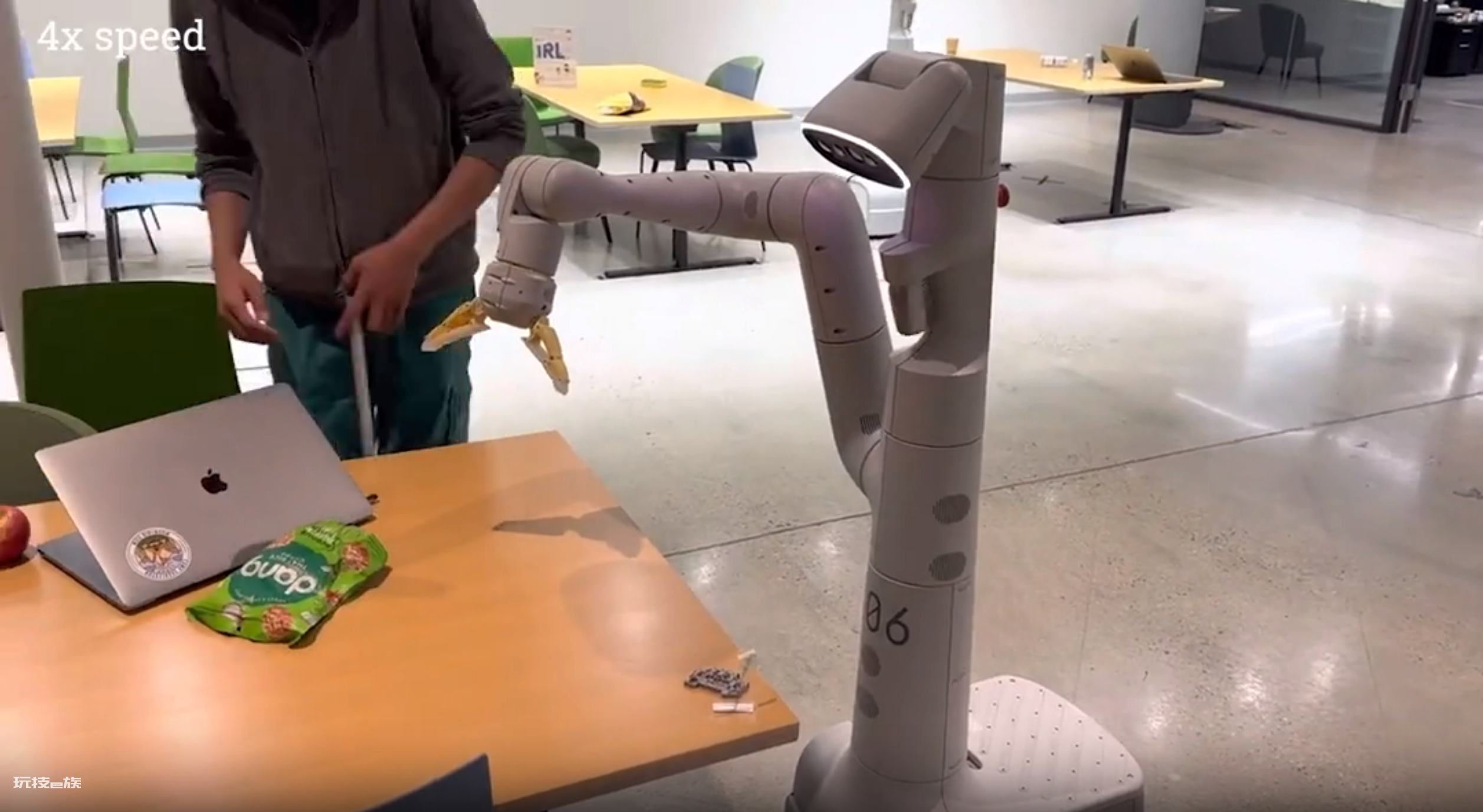

谷歌还提供了一段演示视频,里面展示了在 PaLM-E 的引导下,一个机器人按照指令“给了我一颗绿色的星星”。研究人员说,这颗绿色的星星“是这个机器人之前没有直接接触过的物体。”

除了 RT-1 机器人 transformer 外,PaLM -E 还借鉴了谷歌之前在 ViT-22B 上的工作。ViT-22B 是今年 2 月份公布的一个视觉 transformer 模型。ViT-22B 已经接受过各种视觉任务的训练,比方说图像分类、对象检测、语义分割与给图像加字幕等。

致力于利用神经网络进行机器人控制的研究小组不止 Google Robotics 一个。这项研究让人想到了微软最近发表的那篇论文(《ChatGPT for Robotics》),里面也探讨了用类似的方式将视觉数据以及大型语言模型结合起来,对机器人进行控制。

机器人姑且不谈,谷歌的研究人员观察到了一些有趣的效应,这些效应显然是因为 PaLM-E 用大型语言模型作为核心。首先,它有“正迁移”的表现,这意味着它可以将从一项任务学到的知识和技能迁移到另一项任务,与执行单任务的机器人模型相比,前者的“性能显著高于后者”。

此外,他们还观察到模型规模的一个趋势:“语言模型规模越大,用视觉语言和机器人任务进行训练时就越能保持其语言能力——就数量而言,5620 个参数的 PaLM-E 模型几乎保持了所有的语言能力。 “

PaLM-E 是迄今为止报道过的规模最大的 VLM。尽管只接受过单一图像提示的训练,我们观察到了类似多模态思维链推理与多图像推理等涌现能力的出现。虽然这不是我们工作的重点,但PaLM-E 在 OK-VQA 基准测试上设定了一个新的 SOTA(最佳表现)。

——Danny Driess

研究人员声称,尽管只接受了单图像提示的训练,PaLM-E 也已经展示出了涌现能力,比如多模式思维链推理(可让模型分析包括语言和视觉信息在内的一系列输入)与多图像推理(用多个图像作为输入来做出推理或预测)。就这个意义而言,随着深度学习模型慢慢变得越来越复杂,PaLM-E 似乎会继续给人以惊喜。

谷歌研究人员还计划探索 PaLM-E 在现实世界场景的更多应用,比方说家庭自动化或工业机器人。他们希望 PaLM-E 能够激发更多关于多模态推理与具身化 AI 的研究。

“多模态”这个词现在很热,我们将来会听得越来越多,因为各大公司都想做出看起来够像人类一样执行一般任务的通用人工智能。

译者:boxi。